Sztuczna inteligencja coraz śmielej wkracza do codziennej działalności przedsiębiorstw – wspiera rekrutację, analizę danych klientów, automatyzację procesów biznesowych, a nawet podejmowanie decyzji oparte na modelach predykcyjnych. To, co jeszcze kilka lat temu było domeną firm technologicznych, dziś staje się dostępne dla każdego – od firm e-commerce, przez banki i ubezpieczycieli, aż po sektor MŚP.

Ta technologiczna rewolucja niesie ze sobą ogromne korzyści – szybsze procesy, lepsze dopasowanie oferty, mniejsze koszty operacyjne. Jednak równocześnie stawia firmy przed nowymi wyzwaniami prawnymi i organizacyjnymi. Wdrożenie AI wymaga dziś nie tylko wiedzy technicznej, ale również zrozumienia i przestrzegania skomplikowanego otoczenia regulacyjnego.

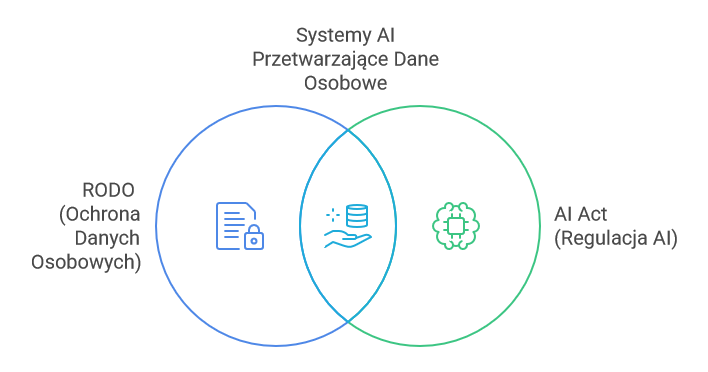

W Unii Europejskiej kluczowe znaczenie mają dwa akty prawne: RODO (ogólne rozporządzenie o ochronie danych osobowych) oraz AI Act – nowa regulacja, która ma ujednolicić zasady korzystania ze sztucznej inteligencji na całym rynku UE. Oba akty mają odrębne cele, ale często dotyczą tych samych sytuacji – zwłaszcza wtedy, gdy systemy AI przetwarzają dane osobowe.

W poniższym artykule wyjaśnimy:

- jak rozpoznać, czy system wykorzystywany w firmie podlega pod AI Act,

- kiedy i jak należy stosować również RODO,

- jakie obowiązki nakładają na firmy oba rozporządzenia,

- oraz jak bezpiecznie i zgodnie z prawem korzystać z AI – niezależnie od branży.

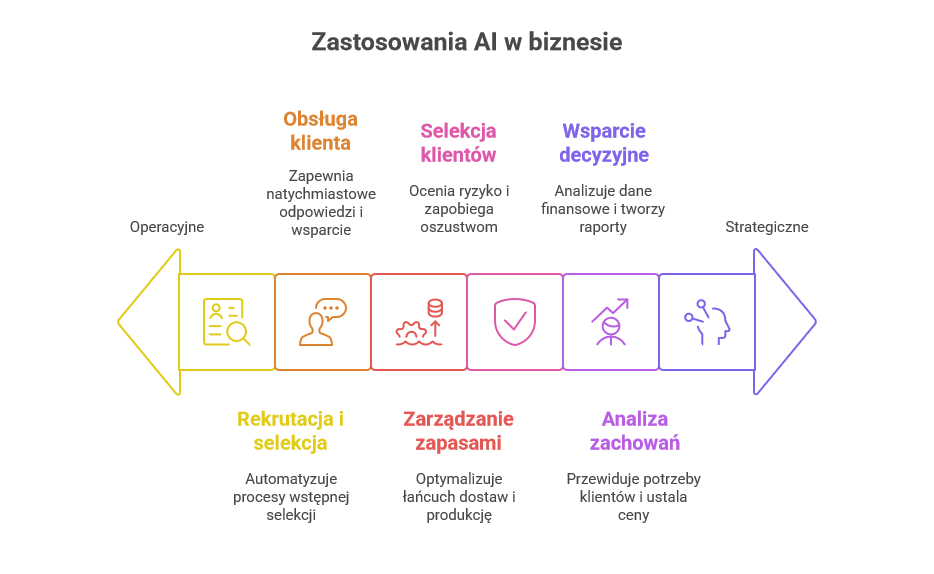

W jakich kontekstach firmy stosują AI?

Zastosowanie sztucznej inteligencji w biznesie nie jest już domeną wyłącznie dużych korporacji technologicznych. Coraz więcej firm – niezależnie od wielkości i branży – wdraża rozwiązania AI w codziennej działalności. W wielu przypadkach są to narzędzia oferowane w modelu SaaS (np. w pakiecie z systemami CRM lub HR), których działanie opiera się na analizie dużych zbiorów danych i podejmowaniu decyzji lub rekomendacji.

Przykłady najczęstszych zastosowań AI w firmach:

- rekrutacja i selekcja kandydatów – systemy wspierające analizę CV, rankingowanie aplikacji, oceny behawioralne na podstawie testów lub nagrań wideo;

- obsługa klienta – chatboty i voiceboty udzielające odpowiedzi 24/7, wspierające automatyczne przyjmowanie reklamacji czy zgłoszeń serwisowych;

- analiza zachowań konsumenckich – profilowanie marketingowe, przewidywanie potrzeb klientów, dynamiczne ustalanie cen;

- selekcja klientów – systemy scoringowe w bankowości, ubezpieczeniach i e-commerce (np. antyfraud, ocena ryzyka kredytowego);

- zarządzanie zapasami i produkcją – optymalizacja łańcucha dostaw na podstawie danych historycznych i predykcji popytu;

- wsparcie decyzyjne – analiza danych finansowych, predykcje sprzedaży, tworzenie automatycznych raportów zarządczych.

Choć wiele z tych rozwiązań przyczynia się do wzrostu efektywności operacyjnej, należy pamiętać, że ich stosowanie wiąże się z przetwarzaniem danych – często osobowych – i może rodzić ryzyka prawne oraz etyczne. Warto zatem odpowiedzieć na pytanie: czy dany system faktycznie podlega regulacjom wynikającym z AI Act?

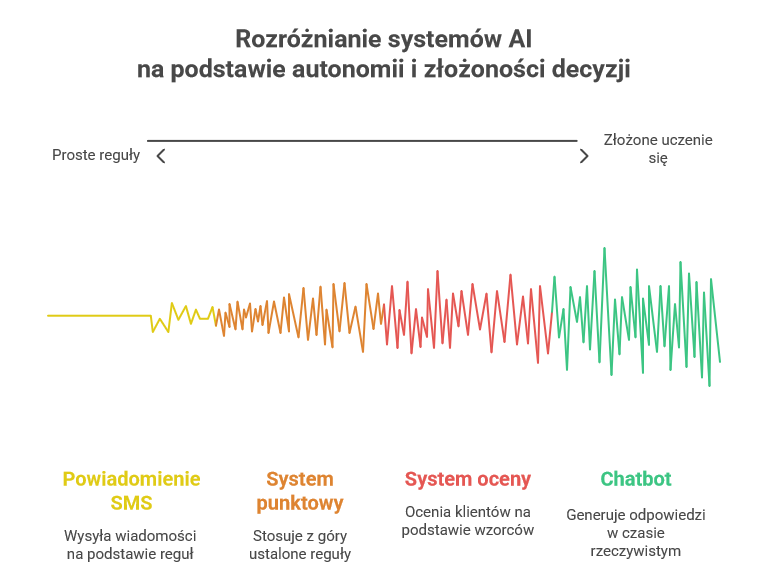

Czy to na pewno system AI? Jak rozpoznać, czy AI Act ma zastosowanie

Wbrew powszechnej narracji marketingowej, nie każde „inteligentne” rozwiązanie jest objęte regulacjami AI Act. To kluczowe rozróżnienie, które pozwala firmom zrozumieć, czy i jakie obowiązki ich dotyczą.

Zgodnie z definicją zawartą w AI Act, system sztucznej inteligencji to oprogramowanie:

„zaprojektowane z wykorzystaniem jednego lub więcej podejść i technik (takich jak uczenie maszynowe, logiczne systemy, podejścia oparte na wiedzy), które dla wyznaczonego zestawu celów generuje treści, prognozy, zalecenia lub decyzje wpływające na środowisko, z którym wchodzi w interakcję”.

Co z tego wynika w praktyce?

- AI to nie każdy algorytm – proste reguły „if-then” nie będą uznane za AI.

- System musi mieć zdolność do uczenia się lub podejmowania decyzji w sposób częściowo autonomiczny.

- Nadmierne „etykietowanie” AI przez dostawców nie przesądza o podleganiu przepisom – liczy się faktyczna funkcjonalność.

Przykłady:

✅ chatbot oparty na modelu językowym generującym odpowiedzi w czasie rzeczywistym – TAK, to AI.

❌ automatyczne powiadomienie SMS wysyłane po wypełnieniu formularza – NIE, to reguła biznesowa.

✅ system oceniający klientów na podstawie wzorców zachowań – TAK, to AI.

❌ system bazujący na z góry ustalonych regułach punktowych – niekoniecznie, zależy od implementacji.

Dopiero po właściwym zakwalifikowaniu rozwiązania jako systemu AI można przejść do analizy jego potencjalnego ryzyka oraz wymagań regulacyjnych – zarówno z AI Act, jak i z RODO.

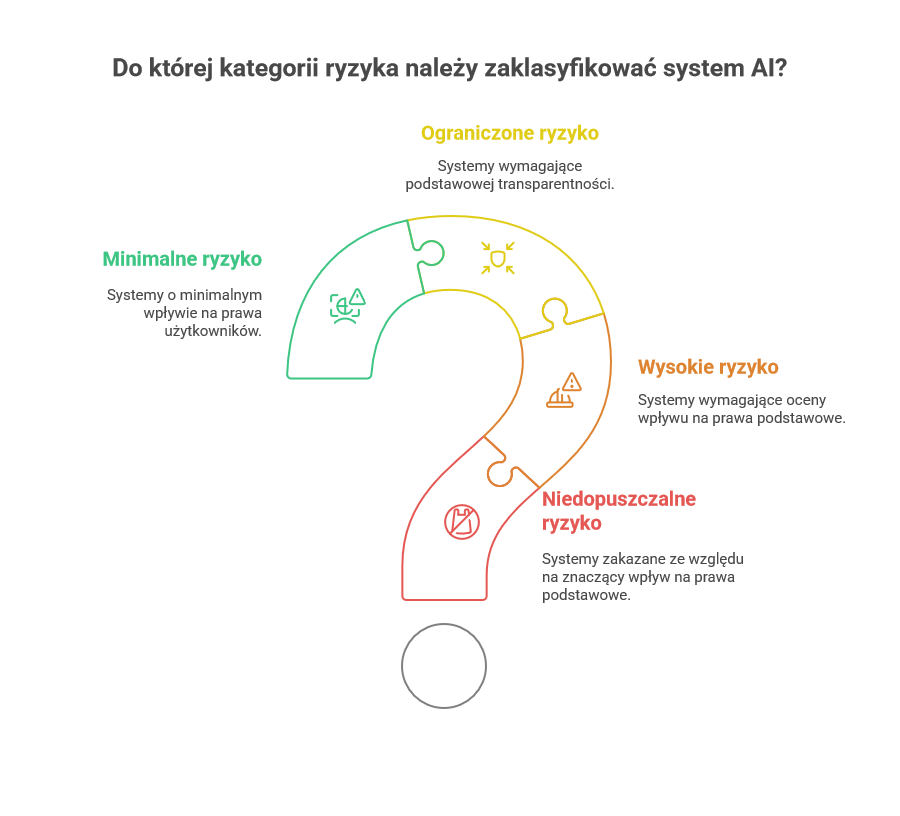

Klasyfikacja ryzyka i obowiązek analizy

Jednym z fundamentów AI Act jest zasada podejścia opartego na ryzyku (risk-based approach). Każdy system sztucznej inteligencji powinien zostać zakwalifikowany do jednej z czterech kategorii ryzyka, od której zależą obowiązki prawne po stronie dostawcy i użytkownika systemu.

Cztery poziomy ryzyka według AI Act

- Niedopuszczalne ryzyko – systemy całkowicie zakazane (np. manipulacja podprogowa, social scoring, masowe pozyskiwanie danych biometrycznych z Internetu).

- Wysokie ryzyko – systemy mające znaczący wpływ na prawa podstawowe ludzi (np. scoring kredytowy, AI w rekrutacji, ocena uczniów, ocena ryzyka ubezpieczeniowego).

- Ograniczone ryzyko – systemy, które wymagają podstawowej transparentności, ale nie podlegają pełnym obowiązkom (np. chatboty informacyjne).

- Minimalne ryzyko – większość prostych narzędzi, np. filtry antyspamowe, rekomendacje filmów, które nie wywołują znaczącego wpływu na prawa użytkowników.

Obowiązek analizy ryzyka

Firmy, które wdrażają system AI – zwłaszcza o wysokim lub ograniczonym ryzyku – muszą przeprowadzić ocenę ryzyka:

- określić potencjalny wpływ na prawa i wolności osób fizycznych,

- przeanalizować dane wejściowe, algorytmiczne uprzedzenia, możliwość nadzoru,

- uwzględnić ryzyka związane z błędami systemu, brakiem interpretowalności wyników czy nadmiernym zaufaniem użytkownika do AI.

Ten obowiązek nie jest nowy – występuje również w RODO (ocena skutków dla ochrony danych – DPIA), w AML (analiza ryzyka klienta), czy w DORA (analiza odporności cyfrowej). W AI Act przyjmuje on postać oceny wpływu na prawa podstawowe (Fundamental Rights Impact Assessment – FRIA) dla systemów wysokiego ryzyka.

AI Act a RODO – wspólne i niezależne obowiązki

Choć AI Act i RODO to dwa odrębne rozporządzenia, ich obszary często się przecinają – szczególnie wtedy, gdy systemy AI przetwarzają dane osobowe. Zrozumienie ich wzajemnej relacji to klucz do zgodnego i bezpiecznego korzystania z AI w firmie.

Niezależne, ale komplementarne

- AI Act nie zastępuje RODO – nie jest przepisem szczególnym (lex specialis), lecz odrębnym reżimem.

- RODO ma zastosowanie do przetwarzania danych osobowych, niezależnie od tego, czy odbywa się ręcznie, automatycznie czy z udziałem AI.

- AI Act obejmuje wszystkie systemy AI, także te, które nie przetwarzają danych osobowych – ale gdy to robią, wchodzi w grę również RODO.

Podwójne obowiązki – jeden cel

W praktyce oznacza to konieczność łącznego stosowania przepisów:

- AI Act wymaga m.in. oceny wpływu na prawa podstawowe, zapewnienia nadzoru ludzkiego, przejrzystości działania i dokumentacji technicznej.

- RODO wymaga m.in. legalności przetwarzania danych (np. zgody lub uzasadnionego interesu), poinformowania osób, których dane dotyczą, oraz zapewnienia im praw (dostępu, usunięcia, sprzeciwu).

- Oba akty wymagają podejścia opartego na ryzyku i dokumentowania działań.

Współdzielenie elementów compliance

Przykłady praktyczne:

- DPIA z RODO może być częściowo wykorzystane w ramach FRIA z AI Act – nie trzeba powtarzać całej analizy.

- Mechanizmy nadzoru ludzkiego (np. audyt wyników decyzji AI) mogą być wspólne dla obu reżimów.

- Procedury informowania użytkowników (np. o działaniu chatbota AI) powinny spełniać wymogi zarówno RODO (transparentność), jak i AI Act (oznaczenie interakcji z AI).

Kluczowe obowiązki wynikające z AI Act i RODO

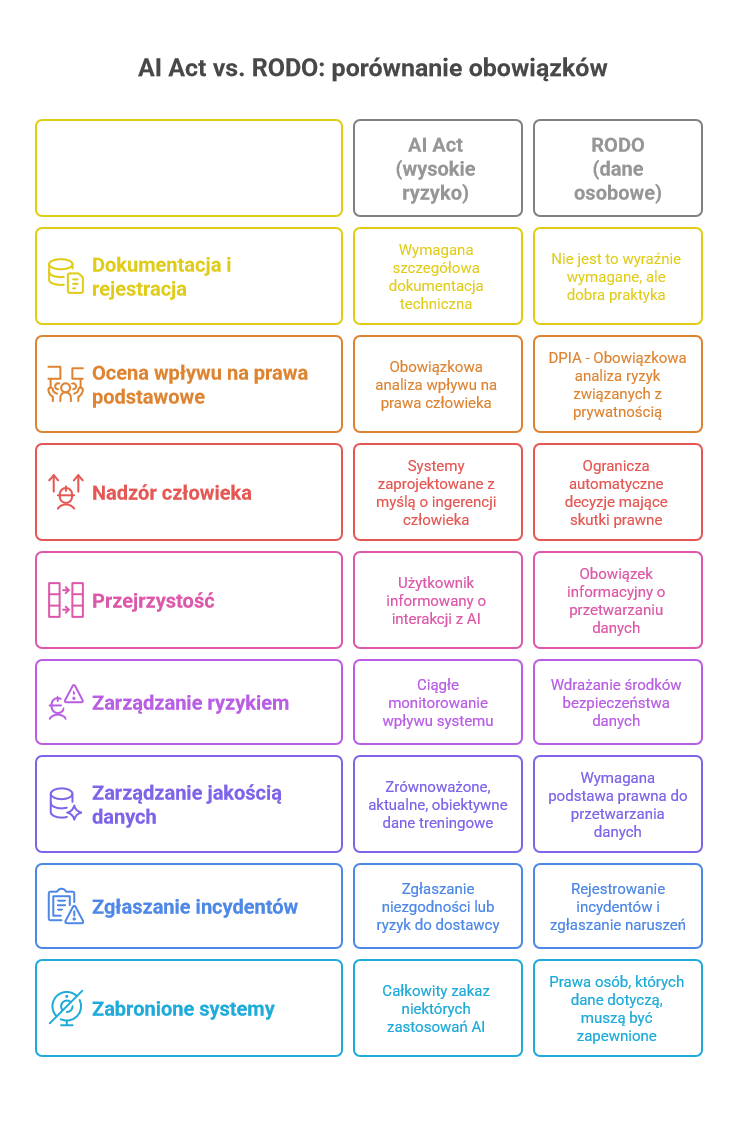

Zarówno AI Act, jak i RODO nakładają na firmy konkretne obowiązki – częściowo odmienne, ale często się uzupełniające. Zrozumienie ich zakresu jest kluczowe dla wdrożenia zgodnego z prawem i bezpiecznego systemu AI.

Obowiązki wynikające z AI Act (dla systemów wysokiego ryzyka):

- Dokumentacja techniczna i rejestracja – wymagane jest prowadzenie szczegółowej dokumentacji technicznej systemu AI oraz rejestru wdrożeń.

- Ocena skutków dla praw podstawowych (FRIA) – obowiązkowa analiza potencjalnego wpływu na prawa człowieka.

- Nadzór człowieka – systemy muszą być projektowane z myślą o umożliwieniu ingerencji człowieka, a nadzór musi być sprawowany przez kompetentne osoby.

- Przejrzystość – użytkownik musi być poinformowany, że wchodzi w interakcję z systemem AI (np. chatbot, analiza emocji).

- Zarządzanie ryzykiem – ciągłe monitorowanie działania systemu AI i jego wpływu na użytkowników.

- Zarządzanie jakością danych – dane treningowe muszą być odpowiednio zbalansowane, aktualne i wolne od uprzedzeń.

- Zgłaszanie nieprawidłowości – obowiązek informowania dostawcy systemu o wszelkich niezgodnościach lub ryzykach.

- Systemy zakazane – całkowity zakaz stosowania AI w niektórych celach (np. manipulacja podprogowa, masowy social scoring).

Obowiązki wynikające z RODO (gdy przetwarzane są dane osobowe):

- Podstawa prawna przetwarzania danych – np. zgoda użytkownika, umowa, uzasadniony interes.

- Obowiązek informacyjny – osoby, których dane są przetwarzane, muszą być jasno poinformowane o celach, zakresie i czasie przetwarzania.

- Realizacja praw podmiotów danych – dostęp do danych, ich poprawienie, usunięcie, przeniesienie, ograniczenie przetwarzania, sprzeciw.

- Ograniczenie automatyzacji decyzji (art. 22) – zakaz podejmowania decyzji wyłącznie przez AI, jeżeli wywołują one istotne skutki prawne, bez możliwości ingerencji człowieka.

- DPIA – ocena skutków dla ochrony danych – obowiązkowa analiza ryzyk dla praw i wolności osób fizycznych.

- Bezpieczeństwo danych (art. 32 RODO) – wdrożenie odpowiednich środków technicznych i organizacyjnych.

- Rejestrowanie incydentów i zgłaszanie naruszeń – obowiązek zgłoszenia naruszeń do PUODO w ciągu 72 godzin.

Obie regulacje wymagają wysokiego poziomu transparentności, odpowiedzialności i dowodzenia zgodności – a więc dobrze udokumentowanych procesów.

Jak korzystać z AI zgodnie z prawem? Praktyczne wskazówki

Wbrew obawom wielu przedsiębiorców – legalne, bezpieczne i skuteczne korzystanie z AI jest możliwe, o ile zostaną spełnione określone warunki. Poniżej zestaw kroków, które warto wdrożyć jako standard compliance w firmie:

👉 Zweryfikuj, czy to w ogóle AI

- Czy system spełnia definicję AI z rozporządzenia?

- Czy podejmuje decyzje lub generuje wnioski w sposób autonomiczny?

- Czy został wytrenowany na danych?

👉 Dokonaj kwalifikacji poziomu ryzyka

- Sprawdź, do której kategorii ryzyka należy system (wysokie, ograniczone, minimalne, zakazane).

- Jeśli wysoki – uruchom pełną procedurę zgodności z AI Act.

👉 Oceń wpływ na dane osobowe

- Czy system przetwarza dane osobowe? Jeśli tak – RODO ma zastosowanie.

- Przeprowadź DPIA i (jeśli wymagane) FRIA.

- Upewnij się, że masz podstawę prawną przetwarzania danych.

👉 Zapewnij nadzór człowieka

- Określ, kto w organizacji odpowiada za działanie i monitorowanie AI.

- Zapewnij możliwość „ręcznej” interwencji, np. w decyzje kredytowe lub rekrutacyjne.

- Wprowadź procedury reagowania na nieprawidłowości.

👉 Informuj użytkowników i klientów

- Komunikuj w sposób jasny, że mają do czynienia z AI.

- Wyjaśnij, jakie dane są przetwarzane i dlaczego.

- Przekaż informacje o możliwości sprzeciwu lub odwołania się od decyzji.

👉 Dokumentuj i monitoruj

- Prowadź rejestr wdrożeń AI i ocen ryzyka.

- Utrzymuj dokumentację systemów i ich ewolucji (szczególnie przy AI uczącym się).

- Regularnie audytuj zgodność i poprawność działania systemu.

Wdrożenie tych zasad nie tylko minimalizuje ryzyko prawne, ale też buduje zaufanie klientów i partnerów – a to w erze AI staje się przewagą konkurencyjną.

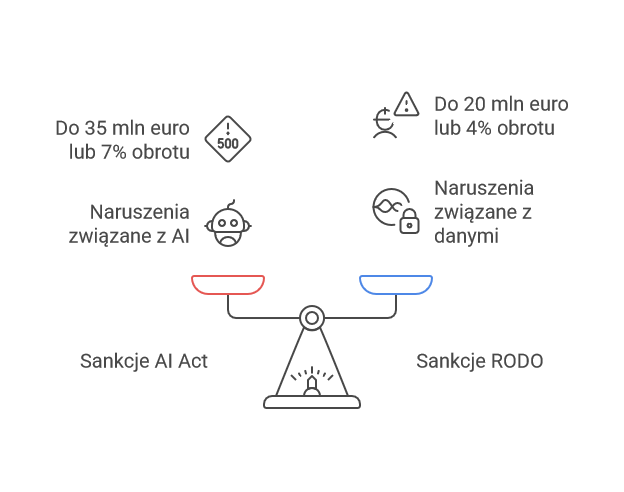

Kary i sankcje – ryzyko nieprzestrzegania regulacji

Zarówno AI Act, jak i RODO przewidują dotkliwe konsekwencje finansowe za nieprzestrzeganie obowiązków. Co istotne, w przypadku naruszeń związanych z przetwarzaniem danych osobowych przez systemy AI, możliwe jest równoległe nałożenie kar z obu reżimów.

Sankcje w AI Act (art. 71)

- Do 35 mln euro lub 7% całkowitego rocznego obrotu – za naruszenie zakazanych praktyk lub brak zgodności z wymogami dotyczącymi danych.

- Do 15 mln euro lub 3% obrotu – za inne naruszenia, w tym niedopełnienie obowiązków informacyjnych, brak nadzoru czy niespełnienie wymagań wobec systemów wysokiego ryzyka.

- Do 7,5 mln euro lub 1% obrotu – za nieprawidłowe informacje przekazywane organom.

Sankcje w RODO (art. 83)

- Do 20 mln euro lub 4% całkowitego rocznego obrotu – za najcięższe naruszenia, np. nielegalne przetwarzanie danych osobowych, brak podstawy prawnej.

- Do 10 mln euro lub 2% obrotu – za niewłaściwą organizację przetwarzania (np. brak DPIA, niewdrożenie środków bezpieczeństwa).

Ryzyko podwójnych kar

Jeśli firma korzysta z systemu AI bez nadzoru ludzkiego (wbrew AI Act) i jednocześnie dopuszcza nielegalne przetwarzanie danych osobowych (wbrew RODO), może zostać ukarana podwójnie. Przykład: zautomatyzowany system oceny klientów podejmujący decyzje kredytowe bez możliwości odwołania i bez zgody klienta.

Czy da się to połączyć? Tak – oto jak

Mimo złożoności regulacji, połączenie wymogów AI Act i RODO jest możliwe i praktyczne – a dla wielu firm wręcz niezbędne. Kluczem jest opracowanie zintegrowanego podejścia do zgodności (compliance).

Wspólny fundament – analiza ryzyka

Zarówno AI Act, jak i RODO wymagają przeprowadzenia oceny skutków – odpowiednio: FRIA (dla systemów AI) i DPIA (dla danych osobowych). W wielu przypadkach elementy tych analiz pokrywają się – warto je zintegrować.

Jedna dokumentacja – dwa cele

Przykład: polityka transparentności i informowania użytkowników może spełniać wymogi obu rozporządzeń, jeśli zawiera:

- informację, że użytkownik kontaktuje się z AI,

- cel i zakres przetwarzania danych,

- wskazanie praw osoby, której dane są przetwarzane.

Wspólne standardy audytu i kontroli

Firmy mogą opracować jeden model kontroli systemów – obejmujący zarówno techniczne aspekty działania AI, jak i zgodność z zasadami prywatności. Pomaga w tym wykorzystanie istniejących ram, np. ISO/IEC 42001 (zarządzanie AI) oraz ISO/IEC 27001 (bezpieczeństwo informacji).

Synergia z już wdrożonym RODO

Firmy, które wcześniej wdrożyły dobre praktyki RODO – rejestry czynności, DPIA, zasady privacy by design – mogą je łatwo rozszerzyć na obszar AI. To znacznie obniża koszt i czas dostosowania do AI Act.

Jak Doradcy365 mogą pomóc?

W obliczu dynamicznych zmian regulacyjnych, coraz więcej firm potrzebuje praktycznego wsparcia w bezpiecznym wdrażaniu sztucznej inteligencji. W Doradcy365 oferujemy specjalistyczne usługi doradcze, które łączą znajomość przepisów prawa (AI Act, RODO, AML) z praktycznym podejściem do nowych technologii. Pomagamy firmom osiągnąć zgodność bez blokowania innowacyjności.

Nasze usługi obejmują:

☑ Audyt zgodności AI z RODO i AI Act

Kompleksowa analiza rozwiązania AI w kontekście:

- kwalifikacji systemu zgodnie z AI Act,

- oceny przetwarzania danych osobowych (RODO),

- przypisania poziomu ryzyka (AI Act),

- zidentyfikowania luk formalnych i technicznych.

Produkt idealny dla firm wdrażających chatboty, scoring, personalizację ofert lub zautomatyzowane procesy decyzyjne.

☑ Opracowanie procedur i dokumentacji dla systemów AI

Przygotowanie wymaganych dokumentów:

- ocena skutków (DPIA + FRIA),

- procedury nadzoru człowieka nad AI,

- wzory komunikatów informacyjnych zgodnych z AI Act i RODO,

- polityka transparentności i rejestr systemów.

Usługa rekomendowana dla instytucji finansowych, HR Tech, e-commerce i firm usługowych korzystających z AI.

☑ Szkolenie: AI zgodnie z prawem – obowiązki i dobre praktyki

Szkolenie online dla zespołów zarządzających, compliance, IT i marketingu, obejmujące:

- podstawy AI Act i relację z RODO,

- identyfikację systemów AI w firmie,

- zasady oceny ryzyka i obowiązki informacyjne,

- praktyczne studia przypadków (np. chatbot, scoring, rekrutacja).

Możliwość realizacji z dostosowaniem do branży klienta.

Wszystkie nasze usługi mogą zostać rozszerzone o doraźne doradztwo lub wdrożenie pełnego systemu compliance dla AI.

Z Doradcy365 możesz działać nowocześnie – i zgodnie z przepisami.

Podsumowanie i rekomendacje dla firm

Technologie oparte na sztucznej inteligencji to ogromna szansa na rozwój, ale tylko wtedy, gdy są wykorzystywane w sposób zgodny z prawem i odpowiedzialny. AI Act i RODO to dwa akty, które trzeba rozumieć i stosować łącznie – nie jako barierę, lecz jako ramy bezpiecznego wdrażania innowacji.

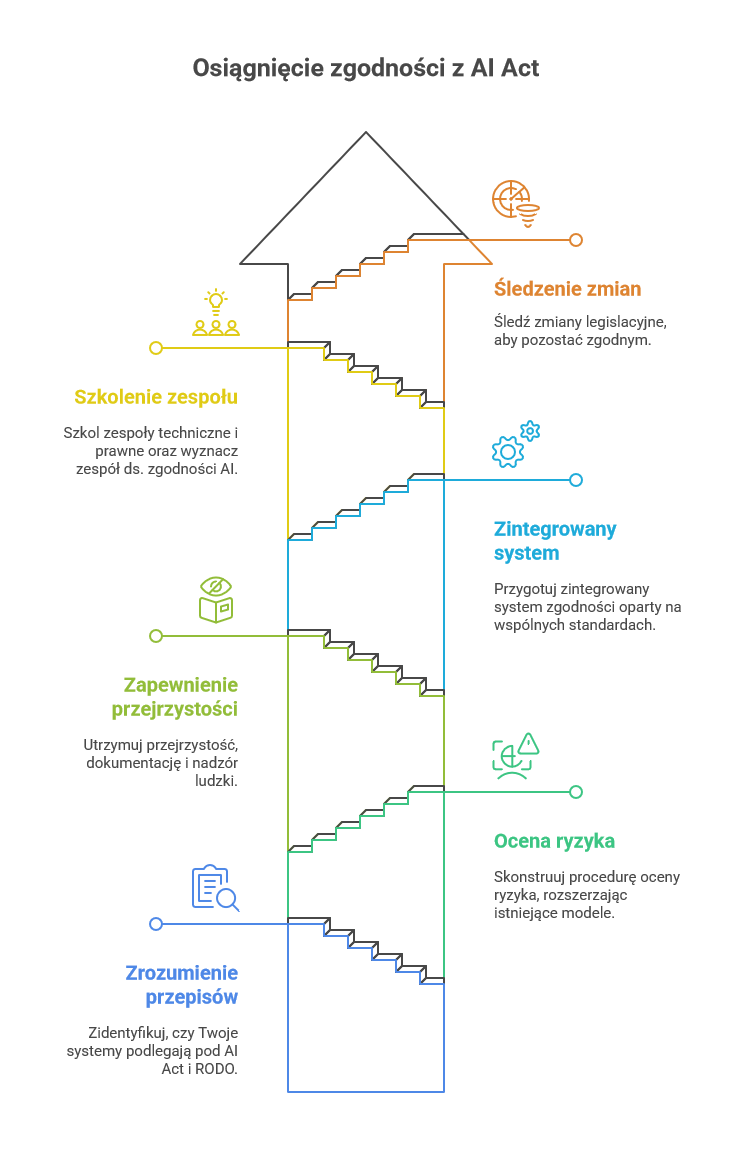

Rekomendacje dla firm:

- Zweryfikuj, czy Twoje systemy podlegają pod AI Act i RODO – nie sugeruj się marketingiem dostawców, tylko definicjami prawnymi.

- Skonstruuj procedurę oceny ryzyka – wykorzystaj istniejące modele z RODO i rozszerz je o wymagania AI Act.

- Zadbaj o przejrzystość, dokumentację i nadzór ludzkiego czynnika – niezależnie od poziomu ryzyka.

- Przygotuj zintegrowany system compliance – oparty na wspólnych standardach dla danych i AI.

- Przeszkol zespół – techniczny i prawny – oraz powołaj osobę lub zespół ds. zgodności AI.

- Śledź zmiany legislacyjne – AI Act to dopiero początek unijnej strategii dla sztucznej inteligencji.

Warto działać już teraz. Dostosowanie firmy do nowych wymogów zajmuje czas, a odpowiedzialne wdrożenie AI może być nie tylko zgodne z prawem, ale też źródłem realnej przewagi konkurencyjnej.

Skorzystaj z naszej pomocy już dziś i uzyskaj wsparcie.

Masz więcej pytań? Zapraszamy do kontaktu

Powyższy artykuł został opracowany przy wsparciu narzędzi AI z wykorzystaniem materiałów wygenerowanych przez model językowy ChatGPT. Treść została zredagowana i zweryfikowana przez autora publikacji.