Artykuł zawiera treści promocyjne oraz lokowanie produktów związanych z ofertą Doradcy365. Informacje przedstawione w artykule mają na celu zarówno edukację, jak i zaprezentowanie naszych usług, które mogą pomóc w skutecznej ochronie przed zagrożeniami w sieci.

Sztuczna inteligencja to jedno z najważniejszych osiągnięć współczesnej technologii, które zmienia nasze życie w niemal każdej dziedzinie. Od medycyny, przez edukację, aż po codzienne funkcjonowanie – AI pomaga nam działać szybciej, skuteczniej i bardziej efektywnie. Jednak tak jak każda innowacja, niesie ze sobą także ciemne strony. Coraz częściej słyszymy o przypadkach, gdy AI jest wykorzystywana nie w celu rozwoju i wsparcia, ale jako narzędzie przestępcze.

Wyobraź sobie sytuację, w której odbierasz telefon od kogoś, kto brzmi dokładnie jak bliska Ci osoba, prosząc o pilną pomoc finansową. Albo przypadek, gdy widzisz wideo rzekomo przedstawiające znanego polityka wygłaszającego kontrowersyjne oświadczenie, które w rzeczywistości nigdy nie miało miejsca. To nie scenariusze science-fiction, ale realne przykłady działań cyberprzestępców, którzy dzięki sztucznej inteligencji są w stanie tworzyć deepfake, klonować głosy czy automatyzować ataki phishingowe.

W dobie postępującej cyfryzacji umiejętność rozpoznawania tego rodzaju zagrożeń oraz wiedza na temat sposobów ochrony stają się kluczowe. Ten artykuł pomoże ci zrozumieć, jak technologia sztucznej inteligencji może zostać wykorzystana przeciwko nam, jakie techniki stosują oszuści oraz jak skutecznie bronić się przed nowoczesnymi formami cyberprzestępczości.

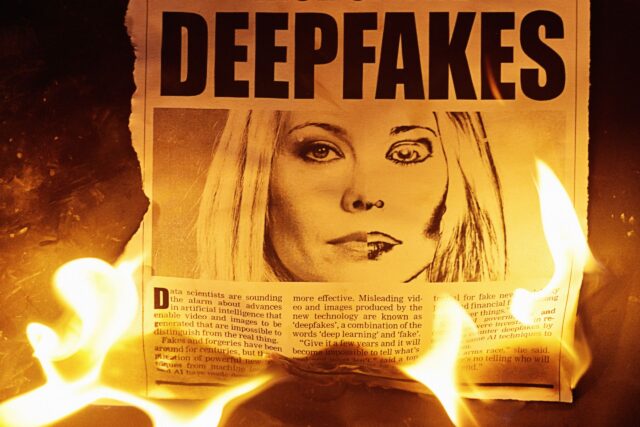

Deepfake: fałszywe obrazy i filmy

Technologia deepfake, będąca połączeniem słów “deep learning” (głębokie uczenie) i “fake” (fałszywy), umożliwia tworzenie obrazów, wideo i nagrań dźwiękowych, które na pierwszy rzut oka wydają się autentyczne, ale w rzeczywistości są zmanipulowane. Dzięki zastosowaniu zaawansowanych algorytmów uczenia maszynowego, deepfake pozwala na wierne odwzorowanie wyglądu, mimiki, a nawet głosu konkretnej osoby.

Jak działa deepfake?

Algorytmy deepfake uczą się na podstawie dużej ilości danych – zdjęć, nagrań wideo czy głosowych – aby jak najdokładniej naśladować cechy charakterystyczne danej osoby. Technologia ta wykorzystuje sieci neuronowe, zwłaszcza tzw. sieci generatywne przeciwników (GAN), które w procesie iteracyjnym doskonalą generowane treści. W praktyce oznacza to, że im więcej materiałów o danej osobie jest dostępnych w internecie, tym łatwiej stworzyć realistyczny deepfake.

Przykłady wykorzystania deepfake

Choć deepfake może mieć zastosowania rozrywkowe i edukacyjne, takie jak tworzenie realistycznych efektów specjalnych czy rekonstrukcja postaci historycznych, niestety jest też coraz częściej wykorzystywany w sposób nieetyczny i przestępczy. Oto kilka przykładów:

- Polityka i dezinformacja: deepfake stały się narzędziem manipulacji w kampaniach politycznych. Fałszywe filmy przedstawiające polityków wypowiadających kontrowersyjne opinie mogą wpłynąć na wybory lub destabilizować społeczeństwo.

- Szantaż i kompromitacja: cyberprzestępcy używają deepfake do tworzenia fałszywych nagrań wideo lub zdjęć o charakterze kompromitującym, które następnie wykorzystują do szantażowania ofiar.

- Kradzież tożsamości: oszuści mogą podszywać się pod znane osoby lub celebrytów, aby oszukać fanów, uzyskać dostęp do ich środków finansowych lub promować fałszywe inicjatywy.

- Oszustwa finansowe: Coraz częściej deepfake jest używany w sektorze korporacyjnym. Przykładem może być fałszywe wideo rzekomego dyrektora firmy instruującego pracowników o przelaniu pieniędzy na wskazane konto.

Jak rozpoznać deepfake?

Pomimo zaawansowania technologii deepfake, istnieją pewne oznaki, które mogą wskazywać, że materiał wideo lub dźwiękowy został zmanipulowany. Jednym z pierwszych sygnałów jest nienaturalne zachowanie twarzy i ciała osoby przedstawionej w materiale. Ruchy ust, mruganie czy mimika mogą być niespójne z resztą ciała, co wprowadza subtelne, ale zauważalne nieprawidłowości. Na przykład oczy mogą poruszać się w sposób nienaturalny lub twarz może wyglądać jakby była „przyklejona” do ciała.

Kolejnym aspektem są artefakty wizualne, które wynikają z niedoskonałości algorytmu tworzącego deepfake. Mogą to być zniekształcone krawędzie wokół twarzy, brak naturalnych cieni czy nienaturalne odcienie skóry, które różnią się od reszty obrazu. Często zdarza się, że wideo deepfake wygląda dobrze na pierwszy rzut oka, ale przy bliższej analizie ujawnia subtelne niedociągnięcia, które mogą wskazywać na manipulację.

Równie ważna jest analiza dźwięku w materiale. Klonowany głos, choć może brzmieć bardzo podobnie do oryginału, często charakteryzuje się lekką nienaturalnością, szczególnie w przypadku nietypowych emocji czy intonacji. Wypowiedzi mogą wydawać się mechaniczne, pozbawione naturalnej dynamiki lub zbyt jednolite w tonie. Takie niespójności, zarówno wizualne, jak i dźwiękowe, mogą być cennymi wskazówkami pomagającymi wykryć deepfake.

Jak chronić się przed deepfake?

👉 Weryfikacja źródła

Zawsze sprawdzaj, czy film, zdjęcie lub nagranie pochodzi z wiarygodnego źródła, szczególnie jeśli budzi twoje podejrzenia. Treści publikowane na podejrzanych stronach, anonimowych profilach w mediach społecznościowych czy udostępniane w wiadomościach prywatnych bez dodatkowych informacji mogą być zmanipulowane. Warto zwrócić uwagę na kontekst publikacji – czy materiał został opublikowany przez oficjalny kanał, autoryzowaną osobę czy uznane media? Dodatkowo, porównanie z innymi źródłami informacji, np. sprawdzenie, czy inne media również podają te same fakty, może pomóc w weryfikacji autentyczności treści.

👉 Ograniczenie dostępności materiałów w sieci

Jednym z najprostszych sposobów ochrony przed deepfake jest ograniczenie ilości publikowanych zdjęć i nagrań głosowych w internecie. Im mniej materiałów dostępnych publicznie, tym trudniej cyberprzestępcom stworzyć realistyczny deepfake. Dotyczy to zwłaszcza mediów społecznościowych – warto korzystać z ustawień prywatności, aby kontrolować, kto ma dostęp do twoich treści. Ponadto warto zastanowić się przed publikacją nagrań głosowych czy wideo, zwłaszcza w sytuacjach, gdy nie jest to absolutnie konieczne. Takie podejście ogranicza bazę danych, z której mogą korzystać przestępcy.

👉 Korzystanie z narzędzi detekcji

W odpowiedzi na rozwój technologii deepfake powstają coraz bardziej zaawansowane aplikacje i algorytmy, które umożliwiają identyfikację treści generowanych przez AI. Narzędzia te analizują materiał pod kątem artefaktów wizualnych, niespójności w synchronizacji dźwięku z obrazem czy nienaturalnych ruchów twarzy. Warto śledzić rozwój takich rozwiązań i wykorzystywać je, zwłaszcza w środowiskach, gdzie ryzyko manipulacji deepfake jest wysokie, np. w mediach, sektorze publicznym czy w pracy zawodowej. Dzięki wykorzystaniu tych technologii można zyskać dodatkową warstwę ochrony i zwiększyć pewność co do autentyczności materiałów.

Chociaż wyrafinowane oszustwa z wykorzystaniem deepfake nie są jeszcze tak popularne jak inne cyberataki, to jest jedynie kwestią czasu, kiedy ich liczba wzrośnie. Eksperci przewidują, że deepfake będzie stawać się coraz bardziej zaawansowany i trudniejszy do wykrycia. Dlatego edukacja w zakresie rozpoznawania tego typu manipulacji oraz rozwój narzędzi przeciwdziałających są kluczowe dla zachowania bezpieczeństwa w cyfrowym świecie.

Klonowanie głosu: podszywanie się pod bliskich

Klonowanie głosu to technologia oparta na sztucznej inteligencji, która pozwala na wierne odwzorowanie mowy dowolnej osoby. Wystarczy krótkie nagranie, często trwające zaledwie kilka sekund, aby algorytm AI mógł naśladować barwę, intonację i sposób mówienia konkretnej osoby. Niestety, to potężne narzędzie znajduje zastosowanie nie tylko w rozrywce czy edukacji, ale także w działaniach przestępczych.

Jak działa klonowanie głosu?

Proces klonowania głosu opiera się na zaawansowanych algorytmach uczenia maszynowego. System analizuje cechy dźwięku, takie jak ton, rytm mowy czy akcent, a następnie generuje syntetyczne wypowiedzi na ich podstawie. Dzięki technologiom takich jak modele TTS (Text-to-Speech) i narzędzia do generowania głosu, oszuści mogą stworzyć nagrania, które brzmią niemal identycznie jak wypowiedzi oryginalnego mówcy.

Przykłady oszustw z wykorzystaniem klonowania głosu

- Fałszywe telefony od bliskich: przestępcy dzwonią do ofiary, podszywając się pod członka rodziny lub przyjaciela, i proszą o pilną pomoc finansową. Ofiara, słysząc znajomy głos, rzadko weryfikuje sytuację, działając pod wpływem emocji.

- Oszustwa korporacyjne: klonowanie głosu bywa używane do wyłudzenia pieniędzy od firm. W jednym z głośnych przypadków dyrektor brytyjskiej firmy przelał 220 tysięcy euro na konto przestępców, wierząc, że rozmawia ze swoim przełożonym, który w rzeczywistości nigdy nie wykonał telefonu.

- Podszywanie się pod instytucje: dzięki klonowaniu głosu oszuści mogą udawać przedstawicieli banków, operatorów telefonicznych czy innych instytucji, zdobywając w ten sposób dane wrażliwe, takie jak numery kont czy kody dostępu.

- Szantaż emocjonalny: w pewnym z przypadków matka usłyszała w słuchawce zapłakany głos swojej córki, która rzekomo została porwana. Oszuści zażądali okupu, zanim kobieta zdołała skontaktować się z córką inną drogą i odkryła, że ta była bezpieczna.

Czy można rozpoznać sklonowany głos?

Choć technologia klonowania głosu osiągnęła imponujący poziom zaawansowania, istnieją pewne wskazówki, które mogą pomóc w rozpoznaniu oszustwa. Warto zwracać uwagę na szczegóły, które mogą wskazywać na manipulację.

➡ Nietypowy kontekst rozmowy

Jeśli rozmowa zawiera nietypowe prośby lub pytania, które nie pasują do zwyczajowego zachowania osoby, warto być szczególnie czujnym. Na przykład, gdy bliski znajomy, który nigdy wcześniej nie prosił o pieniądze, nagle dzwoni z pilną prośbą o przelew, należy zachować ostrożność. Oszuści często wykorzystują emocje, presję czasu lub rzekome sytuacje kryzysowe, aby skłonić do działania bez zastanowienia. Warto zwrócić uwagę, czy styl rozmowy, wybór słów lub sposób formułowania zdań pasują do tego, co znamy z wcześniejszych kontaktów z daną osobą.

➡ Brak naturalnych odgłosów w tle

Syntetyczne nagrania tworzone za pomocą technologii klonowania głosu często brzmią zbyt „czysto” i pozbawione są naturalnych odgłosów otoczenia. W rozmowach telefonicznych zwykle słychać subtelne dźwięki tła, takie jak szum ulicy, odgłosy w domu czy szelest ubrania. Jeśli rozmowa jest podejrzanie „sterylna” i pozbawiona takich elementów, może to być sygnał, że mamy do czynienia z klonowanym głosem.

➡ Nietypowa intonacja lub tempo mowy

Klonowane głosy, choć mogą brzmieć bardzo podobnie do oryginału, często mają trudności z odwzorowaniem pełnej naturalności mowy. Można zauważyć nienaturalne przerwy między słowami, monotonne brzmienie lub nietypową intonację. Na przykład, osoba, którą dobrze znamy, może nagle brzmieć zbyt emocjonalnie w sytuacjach, w których zwykle pozostaje spokojna, lub odwrotnie – wykazywać brak emocji w kryzysowych sytuacjach. Drobne błędy w rytmie mowy, takie jak zbyt szybkie lub zbyt wolne wypowiadanie słów, również mogą wskazywać na manipulację.

➡ Brak spójności w odpowiedziach

Głos sklonowany przez AI może mieć problem z naturalnym reagowaniem na spontaniczne pytania lub zmiany w rozmowie. Jeśli masz wątpliwości, spróbuj zadać nieoczekiwane pytanie lub poprosić rozmówcę o powtórzenie informacji. Odpowiedź, która wydaje się mechaniczna, z opóźnieniem lub niespójna z wcześniejszymi wypowiedziami, może wskazywać na klonowanie głosu.

➡ Nieodpowiedni poziom emocji

Technologia klonowania głosu ma trudności z realistycznym odwzorowaniem skomplikowanych emocji. Głos może brzmieć zbyt jednostajnie lub „płasko” w sytuacjach, które normalnie wywołują silne emocje, takie jak złość, smutek czy podekscytowanie. Na przykład, jeśli ktoś dzwoni z rzekomo dramatyczną prośbą, a jego głos nie oddaje odpowiedniego poziomu emocji, może to być sygnał ostrzegawczy.

➡ Sprawdzenie autentyczności przez inne kanały

W przypadku wątpliwości, zawsze warto zweryfikować tożsamość rozmówcy innym sposobem. Możesz zadzwonić do osoby, która rzekomo się z tobą kontaktowała, używając innego numeru telefonu lub kanału komunikacji, np. wysyłając wiadomość tekstową czy e-mail. Dodatkowo, ustalanie z bliskimi haseł bezpieczeństwa lub specjalnych fraz, które pozwalają na potwierdzenie tożsamości w takich sytuacjach, może znacząco zwiększyć bezpieczeństwo.

Jak się chronić przed klonowaniem głosu?

Aby chronić się przed zagrożeniem klonowania głosu, warto przede wszystkim ograniczyć publiczne udostępnianie swoich nagrań głosowych. Im mniej takich materiałów dostępnych jest w internecie, tym trudniej przestępcom zdobyć próbki niezbędne do stworzenia realistycznego klonu. Dotyczy to szczególnie mediów społecznościowych i nagrań wideo, które często zawierają wystarczająco dużo materiału, aby algorytmy sztucznej inteligencji mogły dokładnie odwzorować barwę, ton i sposób mówienia danej osoby. Zachowanie ostrożności w udostępnianiu treści może znacząco zmniejszyć ryzyko wykorzystania głosu do celów przestępczych.

Dobrym sposobem na zwiększenie bezpieczeństwa jest także stosowanie haseł weryfikacyjnych. Warto ustalić z rodziną, przyjaciółmi lub współpracownikami specjalne hasło lub frazę, która pozwoli w łatwy sposób potwierdzić tożsamość w sytuacjach kryzysowych. Dzięki temu, nawet jeśli oszust użyje sklonowanego głosu, brak znajomości hasła uniemożliwi mu skuteczne przeprowadzenie ataku.

Kolejną istotną zasadą jest weryfikacja nietypowych próśb. Jeśli otrzymasz telefon od bliskiej osoby, która prosi o pilną pomoc finansową, nie podejmuj pochopnych działań. Skontaktuj się z daną osobą innym kanałem komunikacji, np. wysyłając wiadomość SMS, korzystając z innego numeru telefonu lub poprzez aplikację społecznościową, aby upewnić się, że rozmowa była autentyczna. Takie działanie pozwoli uniknąć sytuacji, w której emocje biorą górę nad rozsądkiem.

Warto również korzystać z zaawansowanych narzędzi weryfikacyjnych, szczególnie w środowisku zawodowym lub w instytucjach o wysokim ryzyku cyberprzestępstw. Firmy i organizacje mogą wdrażać systemy analizy dźwięku, które pozwalają na identyfikację syntetycznych nagrań. Takie technologie potrafią wykrywać subtelne różnice między głosem naturalnym a tym generowanym przez sztuczną inteligencję, co zwiększa ochronę przed tego typu zagrożeniami.

Świadomość zagrożeń związanych z klonowaniem głosu oraz konsekwentne stosowanie powyższych zasad pozwalają skutecznie chronić się przed oszustwami opartymi na tej technologii. Warto zachować ostrożność i nie ulegać presji w sytuacjach, które wydają się nietypowe lub podejrzane.

Tak jak w przypadku deepfake, technologia klonowania głosu będzie w przyszłości prawdopodobnie coraz bardziej doskonała, co utrudni jej wykrycie. Jednocześnie rozwijają się metody obrony, takie jak algorytmy wykrywające syntetyczny dźwięk. Jednak kluczowym elementem ochrony jest edukacja i świadomość, jak rozpoznawać i unikać tego rodzaju oszustw.

Automatyzacja złośliwego oprogramowania

Automatyzacja złośliwego oprogramowania (ang. malware) to jeden z najnowszych i najbardziej niepokojących trendów w cyberprzestępczości. Dzięki wykorzystaniu sztucznej inteligencji (AI) i uczenia maszynowego, cyberprzestępcy tworzą oprogramowanie, które potrafi nie tylko zainfekować system, ale również adaptować się do zmiennych warunków i unikać wykrycia. Automatyzacja sprawia, że ataki stają się bardziej skuteczne, trudniejsze do zneutralizowania i szeroko zakrojone.

Na czym polega automatyzacja malware?

Tradycyjne złośliwe oprogramowanie działa według określonego wzorca, co czyni je stosunkowo łatwym do zidentyfikowania przez programy antywirusowe. Automatyzacja z wykorzystaniem AI wprowadza nowy poziom zaawansowania:

- Samodzielna modyfikacja kodu: AI pozwala malware na ciągłe zmiany w swoim kodzie, co utrudnia jego wykrycie przez narzędzia bezpieczeństwa. Tzw. polimorficzne malware potrafi generować unikalne wersje samego siebie przy każdym uruchomieniu.

- Ataki oparte na uczeniu się: złośliwe oprogramowanie analizuje swoje otoczenie, takie jak system operacyjny, sieć czy zainstalowane zabezpieczenia, i dostosowuje swoje działanie do konkretnego celu.

- Automatyczne wyszukiwanie luk: malware wyposażone w AI może przeszukiwać system w poszukiwaniu słabości, np. niezałatanych błędów w oprogramowaniu, i automatycznie wykorzystywać te luki.

- Ukierunkowane ataki: automatyzacja umożliwia prowadzenie precyzyjnych ataków na wybrane cele, np. instytucje finansowe, przedsiębiorstwa czy infrastrukturę krytyczną, zamiast przypadkowego rozprzestrzeniania się w sieci.

Przykłady zautomatyzowanego malware

👉 Kampanie phishingowe wspomagane przez AI: złośliwe oprogramowanie automatycznie generuje i wysyła przekonujące e-maile phishingowe, które są spersonalizowane pod kątem odbiorcy. Dzięki temu zwiększa się szansa na powodzenie ataku.

👉 Ransomware nowej generacji: automatyzowane ransomware, takie jak Maze czy Ryuk, wykorzystuje AI do szybkiego szyfrowania plików ofiar i identyfikowania wartościowych danych, które mogą być użyte w negocjacjach o okup.

👉 Botnety zasilane AI: botnety, czyli sieci zainfekowanych urządzeń, wykorzystują AI do koordynacji działań, np. przeprowadzania ataków DDoS (rozproszonych ataków typu odmowa usługi) na wybrane cele.

Dlaczego automatyzacja malware jest tak groźna?

Automatyzacja malware, czyli złośliwego oprogramowania, stanowi jedno z najgroźniejszych narzędzi współczesnych cyberprzestępców. Jej największym zagrożeniem jest szybkość i skala, z jaką mogą być przeprowadzane ataki. Dzięki zastosowaniu zaawansowanych algorytmów i sztucznej inteligencji, przestępcy są w stanie w krótkim czasie zainfekować tysiące, a nawet miliony urządzeń. Automatyzacja pozwala im nie tylko zwiększyć zasięg działań, ale także wygenerować większe zyski przy jednoczesnym potęgowaniu strat po stronie ofiar. Ataki tego rodzaju mogą być przeprowadzane niemal natychmiastowo, co znacząco utrudnia reakcję i minimalizację szkód.

Dodatkowo, zautomatyzowane malware charakteryzuje się zdolnością do unikania wykrycia. Dynamicznie zmieniający się kod oraz adaptacyjne działanie sprawiają, że tradycyjne systemy zabezpieczeń, takie jak programy antywirusowe, stają się coraz mniej skuteczne. Malware potrafi analizować środowisko, w którym działa, i dostosowywać się do niego, omijając zabezpieczenia i pozostając niewykrytym przez dłuższy czas. Ta elastyczność stanowi ogromne wyzwanie dla specjalistów ds. bezpieczeństwa, którzy muszą nieustannie rozwijać nowe narzędzia ochrony.

Co więcej, rozwój narzędzi do automatyzacji malware i ich coraz większa dostępność na czarnym rynku oznaczają, że nawet osoby bez specjalistycznej wiedzy technicznej mogą stać się cyberprzestępcami. Gotowe pakiety złośliwego oprogramowania, które można łatwo dostosować i uruchomić, sprawiają, że cyberataki przestają być domeną wyłącznie ekspertów. W efekcie liczba potencjalnych zagrożeń rośnie, a poziom trudności ich zwalczania stale się zwiększa.

Automatyzacja malware to nie tylko większa efektywność działań przestępców, ale także nowe wyzwania dla sektora cyberbezpieczeństwa, który musi radzić sobie z coraz bardziej zaawansowanymi i trudnymi do wykrycia zagrożeniami. Dlatego tak istotne jest rozwijanie nowoczesnych technologii ochronnych oraz edukacja użytkowników w zakresie identyfikacji i unikania ataków.

Jak chronić się przed automatyzowanym malware?

✅ Regularne aktualizacje oprogramowania: aktualizacje systemów operacyjnych i aplikacji często zawierają łatki bezpieczeństwa, które eliminują znane luki, mogące być wykorzystane przez malware.

✅ Zaawansowane rozwiązania antywirusowe: współczesne programy ochronne coraz częściej wykorzystują sztuczną inteligencję do identyfikacji i blokowania nowych rodzajów zagrożeń.

✅ Monitorowanie ruchu sieciowego: narzędzia analityczne pomagają wykrywać nietypowe zachowanie w sieci, które może świadczyć o infekcji malware.

✅ Edukacja użytkowników: najlepsze zabezpieczenia nie pomogą, jeśli użytkownicy będą otwierać podejrzane załączniki czy klikać w linki z nieznanych źródeł.

✅ Tworzenie kopii zapasowych: regularne tworzenie kopii danych chroni przed utratą informacji w przypadku ataku ransomware.

Cyberprzestępcy coraz częściej wykorzystują AI do tworzenia złośliwego oprogramowania, które potrafi samoistnie modyfikować swój kod, ucząc się na własnych błędach, aby uniknąć wykrycia i dostosować się do nowego środowiska. Taka automatyzacja sprawia, że ataki stają się trudniejsze do zidentyfikowania i neutralizacji. Eksperci przewidują, że zautomatyzowane malware będzie stawać się coraz bardziej inteligentne, jednak rozwój technologii AI w sektorze bezpieczeństwa cyfrowego daje nadzieję na skuteczne przeciwdziałanie tym zagrożeniom.

Phishing wspomagany przez AI

Phishing, czyli technika wyłudzania poufnych informacji, takich jak dane logowania, numery kart kredytowych czy inne wrażliwe informacje, jest jednym z najpopularniejszych narzędzi cyberprzestępców. Wspomaganie phishingu przez sztuczną inteligencję (AI) wprowadziło nową jakość w tego typu atakach, sprawiając, że stały się one bardziej przekonujące, skuteczne i trudniejsze do wykrycia.

Jak działa phishing wspomagany przez AI?

Tradycyjne wiadomości phishingowe często były pełne literówek, niezręcznie sformułowanych zdań i oczywistych błędów, co sprawiało, że uważne osoby mogły je z łatwością rozpoznać. Jednak AI zmienia zasady gry:

- Tworzenie spersonalizowanych wiadomości: sztuczna inteligencja analizuje dane o ofiarach, takie jak ich aktywność w mediach społecznościowych, zainteresowania czy kontakty, aby tworzyć wiadomości dopasowane do konkretnej osoby.

- Realistyczne sformułowania: dzięki AI generowane treści są gramatycznie poprawne, naturalnie brzmiące i bardziej wiarygodne. Może to być np. e-mail od “przełożonego” z prośbą o szybkie przesłanie raportu lub kliknięcie w załączony link.

- Automatyzacja wysyłki: phishing wspomagany przez AI pozwala na masowe tworzenie i rozsyłanie setek, a nawet tysięcy indywidualnie spersonalizowanych wiadomości w krótkim czasie.

- Deepfake w phishingu: AI może generować realistyczne nagrania głosowe lub wideo, które sprawiają, że ofiara łatwiej uwierzy w autentyczność wiadomości. Przykładem może być fałszywe wideo z „przełożonym” lub „partnerem biznesowym”, który prosi o wykonanie pilnego przelewu.

Przykłady phishingu wspomaganego przez AI

👉 E-maile udające wiadomości od instytucji: cyberprzestępcy podszywają się pod banki, urzędy czy firmy kurierskie, tworząc wiadomości z pozoru identyczne z prawdziwymi. Dzięki AI wiadomości te są spersonalizowane i zawierają dane ofiary, np. jej imię czy historię ostatnich transakcji.

👉 Ataki na przedsiębiorstwa: przykładem jest tzw. spear phishing, czyli wycelowane ataki na kluczowych pracowników firm. AI analizuje ich profile w sieciach społecznościowych, aby stworzyć przekonującą wiadomość od „przełożonego” lub „partnera biznesowego”.

👉 Phishing w mediach społecznościowych: AI generuje fałszywe wiadomości prywatne na platformach takich jak Facebook czy LinkedIn, w których przestępcy podszywają się pod znajomych lub współpracowników ofiary.

Dlaczego phishing wspomagany przez AI jest tak groźny?

Phishing wspomagany przez sztuczną inteligencję jest szczególnie groźny z kilku kluczowych powodów, które sprawiają, że ten rodzaj cyberprzestępczości jest trudniejszy do wykrycia i bardziej skuteczny niż tradycyjne metody.

Przede wszystkim, zastosowanie AI pozwala na tworzenie spersonalizowanych wiadomości, które są dostosowane do konkretnego odbiorcy. Sztuczna inteligencja analizuje dane o ofierze, takie jak aktywność w mediach społecznościowych, zainteresowania czy wcześniejsze interakcje online. Na tej podstawie generowane są treści, które wydają się wiarygodne i budzą większe zaufanie. Dzięki temu zwiększa się szansa, że ofiara kliknie w złośliwy link, otworzy załącznik lub poda swoje dane wrażliwe. Personalizacja eliminuje wiele sygnałów ostrzegawczych, które wcześniej pomagały użytkownikom zidentyfikować phishing, takich jak ogólnikowość wiadomości czy błędy językowe.

Trudność w wykrywaniu phishingu wspomaganego przez AI polega również na tym, że generowane wiadomości mogą być niezwykle dopracowane. Sztuczna inteligencja tworzy treści, które są gramatycznie poprawne, logiczne i pozbawione oczywistych błędów, co sprawia, że nawet doświadczeni użytkownicy internetu mogą mieć problem z odróżnieniem fałszywej wiadomości od prawdziwej. Dodatkowo, AI jest w stanie generować wiadomości w wielu językach, co pozwala na przeprowadzanie ataków w różnych regionach świata z równą skutecznością.

Kolejnym istotnym zagrożeniem jest szybkość i skala, z jaką mogą być przeprowadzane kampanie phishingowe wspomagane przez AI. Automatyzacja pozwala na masowe generowanie wiadomości w krótkim czasie, a każda z nich może być indywidualnie dostosowana do ofiary. Taka skala działań sprawia, że przestępcy są w stanie dotrzeć do tysięcy, a nawet milionów potencjalnych ofiar jednocześnie, co znacząco zwiększa skuteczność ich ataków.

W rezultacie phishing wspomagany przez AI nie tylko stanowi zagrożenie dla pojedynczych użytkowników, ale również dla całych organizacji i instytucji. Cyberprzestępcy wykorzystują tę technologię do ataków na firmy, gdzie kierują swoje wiadomości do konkretnych pracowników, np. członków zarządu lub działów finansowych, aby wyłudzić pieniądze lub wrażliwe dane. Takie precyzyjne i wysoce dopracowane działania sprawiają, że phishing wspomagany przez AI jest jednym z największych wyzwań w obszarze współczesnego cyberbezpieczeństwa.

Jak rozpoznać phishing wspomagany przez AI?

- Podejrzane linki: sprawdź, czy adres URL w wiadomości jest zgodny z oficjalną stroną instytucji. Zwracaj uwagę na literówki i nietypowe rozszerzenia domen.

- Nietypowe prośby: jeśli ktoś prosi cię o podanie danych logowania, wykonanie przelewu lub kliknięcie w załącznik, zastanów się, czy taka prośba jest uzasadniona.

- Brak dodatkowych informacji: fałszywe wiadomości często zawierają pilny ton („natychmiast”, „bez zwłoki”), ale brakuje w nich szczegółów, które mogłyby uwiarygodnić prośbę.

Jak chronić się przed phishingiem wspomaganym przez AI?

✅ Stosuj dwuskładnikowe uwierzytelnianie (2FA): dzięki temu nawet jeśli cyberprzestępcy zdobędą twoje dane logowania, będą mieli trudność z uzyskaniem dostępu do konta.

✅ Zainstaluj oprogramowanie antyphishingowe: nowoczesne programy ochronne potrafią wykrywać fałszywe strony i wiadomości phishingowe.

✅ Edukacja i czujność: regularne szkolenia na temat cyberbezpieczeństwa pomagają zwiększyć świadomość zagrożeń zarówno wśród pracowników firm, jak i użytkowników indywidualnych.

✅ Weryfikuj nadawców wiadomości: jeśli e-mail lub wiadomość SMS wydaje się podejrzana, skontaktuj się bezpośrednio z daną instytucją lub osobą, zanim podejmiesz jakiekolwiek działania.

✅ Ogranicz udostępnianie danych osobowych: im mniej informacji o sobie udostępniasz publicznie, tym trudniej przestępcom przygotować spersonalizowane ataki.

Sztuczna inteligencja umożliwia tworzenie bardziej przekonujących wiadomości phishingowych, które są trudniejsze do odróżnienia od prawdziwych. Dzięki AI oszuści mogą generować spersonalizowane e-maile czy SMS-y, które zwiększają szanse na powodzenie ataku. Wraz z rozwojem sztucznej inteligencji ataki phishingowe będą coraz bardziej wyrafinowane. Możemy spodziewać się jeszcze lepszego dostosowania treści do ofiar i większej integracji takich technologii jak deepfake. Rozwój technologii obronnych, w tym AI wykorzystywanej do wykrywania zagrożeń, daje jednak szansę na skuteczne przeciwdziałanie tym nowoczesnym formom cyberprzestępczości.

Ochrona przed oszustwami z wykorzystaniem AI

W dobie coraz bardziej zaawansowanych technologii cyberprzestępcy wykorzystują sztuczną inteligencję do przeprowadzania precyzyjnych ataków. Dlatego kluczowym elementem ochrony jest świadomość zagrożeń i wdrożenie odpowiednich środków ostrożności.

Ograniczanie udostępniania danych osobowych

Im mniej informacji o sobie udostępniasz publicznie, tym trudniej cyberprzestępcom stworzyć spersonalizowane ataki. Oto kilka praktycznych wskazówek:

- Przegląd mediów społecznościowych: regularnie sprawdzaj ustawienia prywatności na platformach takich jak Facebook, Instagram czy LinkedIn. upewnij się, że dostęp do twoich zdjęć, filmów i informacji osobistych mają tylko zaufane osoby.

- Nie publikuj nagrań głosowych bez potrzeby: klonowanie głosu wymaga próbek dźwięku, dlatego unikaj publikowania nagrań głosowych w otwartych źródłach.

- Zminimalizuj udostępnianie danych kontaktowych: e-mail służbowy czy numer telefonu powinny być dostępne tylko w niezbędnych sytuacjach.

Stosowanie uwierzytelniania dwuskładnikowego (2FA)

Dwuskładnikowe uwierzytelnianie dodaje dodatkową warstwę ochrony do twoich kont cyfrowych:

- Jak działa 2FA? Poza standardowym hasłem wymaga ono drugiego elementu weryfikacji, np. kodu SMS, aplikacji uwierzytelniającej (takiej jak Google Authenticator) lub biometryki (odcisk palca czy skan twarzy).

- Zastosowanie: włącz 2FA na wszystkich platformach, które to oferują – szczególnie na kontach bankowych, e-mailowych i społecznościowych.

Czujność wobec nietypowych próśb

Oszuści często wykorzystują presję czasu lub emocje, aby skłonić cię do nieprzemyślanego działania:

- Weryfikuj tożsamość nadawcy: jeśli otrzymasz prośbę o pomoc finansową lub dane wrażliwe, skontaktuj się z osobą, która rzekomo wysłała wiadomość, innym kanałem (np. telefonicznie).

- Nie klikaj pochopnie w linki: sprawdź adres URL w wiadomości i upewnij się, że prowadzi do wiarygodnej strony.

- Nie ufaj emocjonalnym historiom: szantaże emocjonalne, takie jak groźba porwania czy wypadek bliskiej osoby, często są wykorzystywane przez oszustów.

Ustalanie haseł bezpieczeństwa

W gronie rodziny i bliskich warto ustalić hasła lub frazy, które pozwolą weryfikować tożsamość w sytuacjach kryzysowych:

- Jak to działa? Jeśli otrzymasz pilną wiadomość od bliskiej osoby, poproś ją o podanie ustalonego wcześniej hasła. Brak odpowiedzi lub błędne hasło może wskazywać na próbę oszustwa.

- Zastosowanie w pracy: w środowisku biznesowym warto ustalić procedury weryfikacji dla ważnych decyzji finansowych, np. telefoniczne potwierdzenie polecenia przelewu.

Używanie zaawansowanych narzędzi bezpieczeństwa

Współczesne technologie mogą wspierać cię w walce z oszustwami AI:

- Programy antyphishingowe: narzędzia te analizują treść wiadomości e-mail, wykrywając potencjalnie złośliwe treści.

- Aplikacje do wykrywania deepfake: rozwijają się rozwiązania umożliwiające rozpoznawanie manipulowanych obrazów i wideo.

- Monitorowanie transakcji bankowych: usługi takie jak alerty SMS mogą pomóc w szybkim wykryciu nieautoryzowanych działań na twoim koncie.

Edukacja i świadomość

Najlepszym zabezpieczeniem jest wiedza o zagrożeniach i umiejętność ich rozpoznawania:

- Szkolenia z cyberbezpieczeństwa: regularne szkolenia w miejscu pracy pomagają zwiększyć świadomość zagrożeń wśród pracowników.

- Śledzenie najnowszych zagrożeń: bądź na bieżąco z informacjami o nowych metodach oszustw, korzystając z zaufanych źródeł.

Świadomość istnienia zagrożeń związanych z wykorzystaniem sztucznej inteligencji oraz stosowanie odpowiednich środków ostrożności pozwala na skuteczną ochronę przed nowoczesnymi metodami oszustw. W dobie cyfryzacji ostrożność i zdrowy rozsądek to kluczowe elementy dbania o swoje bezpieczeństwo

Co zrobić w przypadku oszustwa?

Jeśli podejrzewasz, że padłeś ofiarą oszustwa, kluczowe jest szybkie działanie, które może zminimalizować straty i zabezpieczyć Twoje dane oraz finanse. Oto najważniejsze kroki, które powinieneś podjąć:

1. Zabezpiecz swoje konto

- Zablokuj dostęp do konta w banku oraz karty płatnicze powiązane z zainfekowanym kontem. Skontaktuj się z bankiem, dzwoniąc na infolinię pod numer dostępny na oficjalnej stronie internetowej banku lub w aplikacji mobilnej. Nigdy nie korzystaj z numerów podanych w podejrzanych wiadomościach SMS lub e-mailach.

2. Zgłoś sprawę do instytucji finansowej

Jeżeli oszustwo dotyczy Twojego konta bankowego, karty płatniczej lub platformy finansowej (np. Revolut, PayPal), skontaktuj się także z działem obsługi klienta danej instytucji. Większość firm ma procedury umożliwiające zablokowanie podejrzanych transakcji.

3. Zgłoś oszustwo odpowiednim organom

W Polsce przypadki oszustw można zgłaszać do:

- Policji: oszustwo należy zgłosić na najbliższym komisariacie lub online.

- CERT Polska: Cert.pl przyjmuje zgłoszenia dotyczące cyberprzestępczości, w tym phishingu, fałszywych wiadomości e-mail czy złośliwego oprogramowania.

- UOKiK: jeśli sprawa dotyczy oszustw konsumenckich, warto powiadomić Urząd Ochrony Konkurencji i Konsumentów.

4. Zabezpiecz urządzenie

- Przeskanuj swój komputer, telefon lub tablet programem antywirusowym, aby wykryć i usunąć ewentualne złośliwe oprogramowanie.

- Unikaj korzystania z zainfekowanego urządzenia do wprowadzania haseł lub wykonywania transakcji finansowych, dopóki nie upewnisz się, że jest w pełni bezpieczne.

5. Skorzystaj z pomocy ekspertów

Eksperci Doradcy365 oferują kompleksową pomoc w takich sytuacjach, w tym:

- Pomoc w zabezpieczeniu kont i urządzeń.

- Wsparcie techniczne w przypadku cyberataku.

- Pomoc w odzyskiwaniu danych utraconych w wyniku ataku.

- Doradztwo prawne i wsparcie w zgłaszaniu oszustwa odpowiednim organom.

6. Edukacja na przyszłość

Zdobądź wiedzę na temat oszustw, aby zapobiegać podobnym sytuacjom w przyszłości. Dowiedz się, jak rozpoznawać phishing, deepfake czy inne formy manipulacji i jak skutecznie się przed nimi bronić.

Pamiętaj, że szybka reakcja jest kluczowa, aby zminimalizować skutki oszustwa i zabezpieczyć się przed dalszymi stratami. Nie jesteś sam – eksperci Doradcy365 są tutaj, aby pomóc!

Podsumowanie

Sztuczna inteligencja (AI) otwiera przed nami nieskończone możliwości, ale jednocześnie staje się potężnym narzędziem w rękach cyberprzestępców. Oszustwa z wykorzystaniem AI, takie jak deepfake, klonowanie głosu, złośliwe oprogramowanie i phishing wspomagany przez sztuczną inteligencję, zagrażają zarówno jednostkom, jak i organizacjom. Dzięki AI oszuści tworzą bardziej przekonujące i trudniejsze do wykrycia metody wyłudzania danych, pieniędzy i tożsamości.

Technologie takie jak deepfake umożliwiają manipulowanie obrazami i wideo, podszywanie się pod inne osoby, a nawet tworzenie fałszywych kompromitujących materiałów. Klonowanie głosu pozwala na realistyczne naśladowanie mowy, co wykorzystuje się w szantażu czy kradzieży danych. Automatyzacja złośliwego oprogramowania oraz phishing wspomagany przez AI podnoszą skuteczność ataków i utrudniają ich wykrycie.

Aby przeciwdziałać tym zagrożeniom, kluczowe jest stosowanie odpowiednich środków ochrony, takich jak ograniczenie udostępniania danych osobowych, stosowanie uwierzytelniania dwuskładnikowego, weryfikacja nietypowych próśb oraz ustalanie haseł bezpieczeństwa. Zaawansowane narzędzia do wykrywania zagrożeń i regularna edukacja w zakresie cyberbezpieczeństwa mogą znacząco zwiększyć nasze bezpieczeństwo.

Najważniejszym krokiem w ochronie przed oszustwami z wykorzystaniem AI jest świadomość zagrożeń i zachowanie czujności. Rozwój technologii zarówno po stronie atakujących, jak i obrońców, oznacza, że walka z cyberprzestępczością wymaga ciągłej uwagi i dostosowywania się do nowych wyzwań. W świecie zdominowanym przez technologie to zdrowy rozsądek, ostrożność i odpowiednie nawyki stają się naszym najlepszym zabezpieczeniem.

Skorzystaj z naszej pomocy już dziś i uzyskaj wsparcie.

Masz więcej pytań? Zapraszamy do zapoznania się z naszą ofertą w zakresie cyberbezpieczeństwa oraz kontaktu!

Powyższy artykuł został opracowany przy wsparciu narzędzi AI z wykorzystaniem materiałów wygenerowanych przez model językowy ChatGPT. Treść została zredagowana i zweryfikowana przez autora publikacji.